我们正处于智能时代,人工智能正在被广泛应用:从手机到个人电脑,再到汽车、家庭、办公室和工厂……可以预见的是,现阶段智能计算几乎出现在所有设备中,企业对半导体的需求也在呈指数级增长。此时对于企业来说,如何通过人工智能工具和技术,更易于部署这项关键技术,成为数字化转型的关键。

如今,人工智能是行业中最具颠覆性的技术,正在对我们的生活产生极大的影响。几乎每个行业都在寻求部署AI的方式,以提高生产力并推动创新。基于此,英特尔也正在与广泛市场细分领域的客户积极合作,致力于成功将AI部署到他们的业务中。

“去年,当OpenAI发布了ChatGPT后,它成为最快达到1亿用户的应用程序,并迅速改变了世界。”英特尔公司执行副总裁、数据中心与人工智能事业部总经理Sandra Rivera日前在英特尔AI产品战略暨Gaudi2新品发布会上表示,生成式AI和LLMs不仅进一步挖掘AI的潜力,也促使我们开始以不同的方式看待计算,以便以最具成本效益的方式部署这项技术。

事实上,AI的数据流包括广泛而复杂的工作负载和多模态数据集。面对AI的计算需求,并没有一种通用的解决方案。很大一部分AI工作负载是在通用处理器上运行,这也受多重技术和经济因素影响。通用处理器广泛应用于数据摄取阶段和经典机器学习中,用于训练中小型模型。x86架构的大规模普及和其内置的AI能力使通用处理器已经成为解决AI数据流的理想解决方案。

“人们对于像生成式AI这样的LLMs的深度学习训练非常关注。然而,最大的增长动力是AI的优化和部署。这正是通用处理器如内置AI加速器的英特尔至强可扩展处理器的应用领域。”Sandra Rivera透露,英特尔已经优化了基于至强的推理平台,以便在云、网络或智能边缘部署多样化的AI应用程序。

其中,第四代英特尔至强可扩展处理器中集成AI加速器最重要的特性之一,是新的AMX人工智能加速引擎,与上一代相比,它可以提供高达10倍的人工智能推理和训练性能提升。AMX扩大了能够在至强上运行的人工智能工作负载范围,而无需额外的离散加速器。

第四代至强能够支持大多数大型AI模型,包括实时、中等吞吐量、低延迟稀疏推理,以及中、小型规模的训练和边缘推理。此外,通过广泛的生态系统、专用于简化流程的软件工具以及优化的编译器,让客户能够更轻松地部署我们的解决方案。同时,借助oneAPI和OpenVINO,通过提供易于编程,且可在英特尔硬件上扩展的上游优化库,为开发人员提供了使用硬件架构的开放性和可选择性,即可在多种架构上使用一个代码库。

值得一提的是,与其他GPU和CPU相比,第四代英特尔至强可扩展处理器具备卓越的AI训练和推理性能:在AI推理工作负载中,与英伟达A100 GPU相比,至强的推理性能可超5倍,与AMD的64核EPYC CPU相比,至强的推理性能可超2倍; 而在AI训练工作负载中,与英伟达A100 GPU相比,至强拥有近3倍的性能提升。这意味着用户能够在降低成本的同时,提高生产力,并且无需GPU卸载。

“我们对更高级别软件堆栈的投入,帮助开发者更轻松地使用他们所熟悉的AI框架,例如Pytorch、TensorFlow和DeepSpeed。”Sandra Rivera表示,英特尔在与开放的生态系统合作扩展技术方面久经考验,通过对开发者生态系统、工具、技术和开放平台的长期投入,使得英特尔在AI领域内的公司传统得以延续。

尽管英特尔至强可扩展处理器可以运行诸多AI工作负载,但为了支持更大的模型规模和满足广泛的系统需求,需要采用异构计算的方法,使用不同的计算架构。对于这些应用场景,英特尔提供数据中心GPU Max系列和Gaudi深度学习加速器。

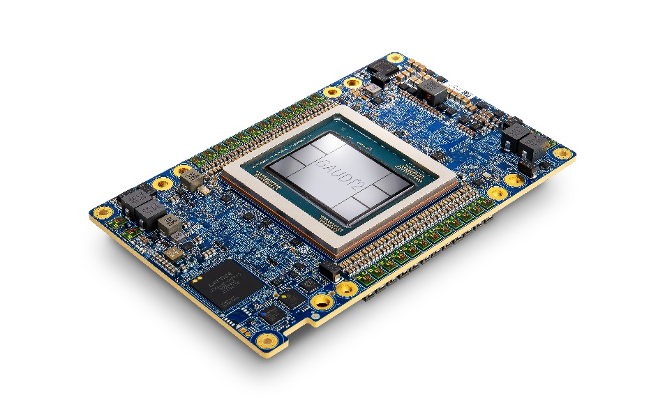

2023年7月11日,英特尔AI产品战略暨Gaudi2新品发布会在京举行。会上,英特尔正式于中国市场推出第二代Gaudi深度学习加速器——Habana® Gaudi®2。

Gaudi2深度学习加速器暨Gaudi2夹层卡HL-225B,以第一代Gaudi高性能架构为基础,以多方位性能与能效比提升,加速高性能大语言模型运行。该加速器具备:24个可编程Tensor处理器核心(TPCs)、21个100 Gbps(RoCEv2)以太网接口、96GB HBM2E内存容量、2.4TB/秒的总内存带宽、48MB片上SRAM以及集成多媒体处理引擎。

Gaudi2加速器的出色性能在6月公布的MLCommons® MLPerf®基准测试中得到了充分认证,其在GPT-3模型、计算机视觉模型ResNet-50(使用8个加速器)、Unet3D(使用8个加速器),以及自然语言处理模型BERT(使用8个和64个加速器)上均取得了优异的训练结果。与市场上其他面向大规模生成式AI和大语言模型的产品相比,Gaudi2拥有卓越的性能与领先的性价比优势,能够帮助用户提升运营效率的同时,降低运营成本。

此外,Gaudi2可为大规模的多模态和语言模型提供出色的推理性能。在最近的Hugging Face评估中,其在大规模推理方面的表现,包括在运行Stable Diffusion(另一个用于从文本生成图像的最先进生成式AI模型之一)、70亿以及1760亿参数BLOOMz模型时,在行业内保持领先。

Gaudi2深度学习加速器的架构旨在高效扩展,以满足大规模语言模型及生成式AI模型的需求。其每张芯片集成了21个专用于内部互联的100Gbps(RoCEv2 RDMA)以太网接口,从而实现低延迟服务器内扩展。

在Stable Diffusion训练上,Gaudi2展示了从1张卡至64张卡近线性99%的扩展性。此外,MLCommons刚刚公布的MLPerf训练3.0结果,亦验证了Gaudi2处理器在1750亿参数的GPT-3模型上,从256个加速器到384个加速器可实现令人印象深刻的接近线性的95%扩展效果。

“英特尔也在中国打造基于Gaudi2的大规模集群,加大投资力度,以进一步扩展对大规模语言模型的AI软件开发支持。”Sandra Rivera强调,英特尔在世界其他地区已经建立了类似基于Gaudi2的集群,并实现了97%的规模效率,这意味着从1个节点到512个节点的性能扩展几乎没有对性能产生影响。这些集群将作为英特尔开发者云的一部分向中国客户提供,在这里客户可以分析和优化从小型到大型的新兴AI工作负载,无需支付昂贵的硬件成本。

为支持客户轻松构建模型,或将当前基于GPU的模型业务和系统迁移到基于全新Gaudi2服务器,并帮助保护软件开发投入,SynapseAI®软件套件针对Gaudi平台深度学习业务进行了优化,旨在与广泛的软件生态系统一起,帮助简化模型的开发和迁移。SynapseAI集成了对TensorFlow和PyTorch框架的支持,并提供众多流行的计算机视觉和自然语言参考模型,能够满足深度学习开发者的多样化需求。

目前,英特尔正与浪潮信息合作,打造并发售基于Gaudi2深度学习加速器的浪潮信息AI服务器NF5698G7。该服务器集成了8颗Gaudi2加速卡HL-225B,还包含双路第四代英特尔至强可扩展处理器。

“构建一个千亿参数规模的大模型训练,仅仅一个节点服务器是不够的,要把它扩展到成百上千的服务器,构成一个集群。此时,节点之间的高速互连就会成为它突出的一个需要解决的瓶颈。”刘军表示,新一代的AI服务器NF5698G7总共能够支持到4800GB的节点间的互连带宽,支持通过RDMA的方式来实现计算网络和存储网络的高速通信,最多能够扩展到一万颗芯片的集群,满足流水线并行和数据并行的高速的通信的要求。

同时,在系统上还做了优化设计,通过精细化的分区,智能散热调控,12V和54V,实现N+N的双输入供电,整个系统的运行功耗相较之前的设计能够降低8%以上;在Gaudi2的软件生态当中,支持PyTorch、TensorFlow两个常见的深度学习框架,以及支持Megatron和DeepSpeed两个大模型训练框架。

写在最后

“英特尔正在通过全方位布局助力中国加速部署和应用AI。基于英特尔标准的异构产品组合,提供经济高效的 AI 解决方案,强化客户在云端通过网络和智能边缘部署这一关键业务技术的能力。”Sandra Rivera强调,未来,英特尔将持续引领产品技术发展,进一步加速大规模深度学习部署,助力中国本地AI市场发展。

京公网安备 11010202008829号

京公网安备 11010202008829号